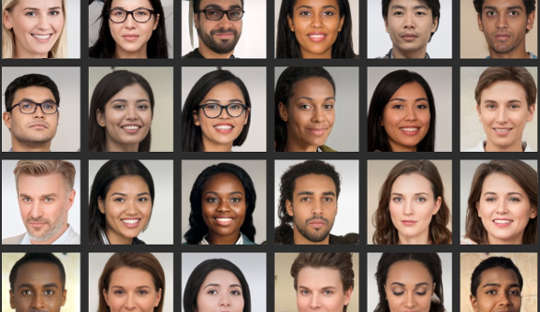

Nawet jeśli myślisz, że jesteś dobry w analizowaniu twarzy, badania pokazują wiele osób nie jest w stanie wiarygodnie odróżnić zdjęć prawdziwych twarzy od obrazów wygenerowanych komputerowo. Jest to szczególnie problematyczne teraz, gdy systemy komputerowe mogą tworzyć realistycznie wyglądające zdjęcia ludzi, którzy nie istnieją.

Niedawno w wiadomościach pojawił się fałszywy profil LinkedIn z wygenerowanym komputerowo zdjęciem profilowym, ponieważ z powodzeniem łączy się z urzędnikami amerykańskimi i innymi wpływowymi osobami na platformie sieciowej, np. Eksperci kontrwywiadu twierdzą nawet, że szpiedzy rutynowo tworzą fantomowe profile z takimi zdjęciami namierzaj zagraniczne cele za pośrednictwem mediów społecznościowych.

Te głębokie podróbki stają się powszechne w codziennej kulturze, co oznacza, że ludzie powinni być bardziej świadomi tego, w jaki sposób są wykorzystywane w marketingu, reklamie i mediach społecznościowych. Obrazy są również wykorzystywane do złych celów, takich jak propaganda polityczna, szpiegostwo i wojna informacyjna.

Tworzenie ich obejmuje coś, co nazywa się głęboką siecią neuronową, systemem komputerowym, który naśladuje sposób, w jaki mózg się uczy. Jest to „trenowane” poprzez wystawianie go na coraz większe zbiory danych prawdziwych twarzy.

W rzeczywistości dwie głębokie sieci neuronowe są ze sobą zestawione, konkurując o uzyskanie najbardziej realistycznych obrazów. W rezultacie produkty końcowe są nazywane obrazami GAN, gdzie GAN oznacza Generative Adversarial Networks. Proces generuje nowe obrazy, które są statystycznie nie do odróżnienia od obrazów treningowych.

W naszym badaniu opublikowanym w iScience, wykazaliśmy, że niemożność odróżnienia tych sztucznych twarzy od prawdziwych ma wpływ na nasze zachowanie w Internecie. Nasze badania sugerują, że fałszywe obrazy mogą podważyć nasze zaufanie do innych i głęboko zmienić sposób, w jaki komunikujemy się online.

Moi koledzy i ja odkryliśmy, że ludzie postrzegali twarze GAN jako jeszcze bardziej realistyczne niż autentyczne zdjęcia twarzy prawdziwych ludzi. Chociaż nie jest jeszcze jasne, dlaczego tak jest, to odkrycie tak zwrócić uwagę na najnowsze osiągnięcia technologiczne wykorzystywane do generowania sztucznych obrazów.

Znaleźliśmy również interesujący związek z atrakcyjnością: twarze, które zostały ocenione jako mniej atrakcyjne, zostały również ocenione jako bardziej realne. Mniej atrakcyjne twarze można uznać za bardziej typowe i typowa twarz może służyć jako punkt odniesienia względem którego oceniane są wszystkie twarze. Dlatego te twarze GAN wyglądałyby bardziej realistycznie, ponieważ są bardziej podobne do mentalnych szablonów, które ludzie zbudowali z codziennego życia.

Ale postrzeganie tych sztucznych twarzy jako autentycznych może mieć również konsekwencje dla ogólnego poziomu zaufania, jakim obdarzamy krąg nieznanych ludzi — pojęcie znane jako „zaufanie społeczne”.

Często czytamy zbyt wiele z twarzy, które widzimy, i pierwsze wrażenia, które tworzymy, kierują naszymi interakcjami społecznymi. W drugim eksperymencie, który stanowił część naszego ostatniego badania, zaobserwowaliśmy, że ludzie są bardziej skłonni ufać informacjom przekazywanym przez twarze, które wcześniej uważali za prawdziwe, nawet jeśli zostały one sztucznie wygenerowane.

Nic dziwnego, że ludzie pokładają większe zaufanie w twarzach, które uważają za prawdziwe. Odkryliśmy jednak, że zaufanie zostało nadszarpnięte, gdy ludzie zostali poinformowani o potencjalnej obecności sztucznych twarzy w interakcjach online. Następnie wykazali ogólnie niższy poziom zaufania – niezależnie od tego, czy twarze były prawdziwe, czy nie.

Wynik ten można uznać za przydatny pod pewnymi względami, ponieważ wzbudził większą podejrzliwość ludzi w środowisku, w którym mogą działać fałszywi użytkownicy. Jednak patrząc z innej perspektywy, może to stopniowo osłabiać samą naturę sposobu, w jaki się komunikujemy.

Ogólnie rzecz biorąc, mamy tendencję do operowania domyślne założenie, że inni ludzie są zasadniczo prawdomówni i godni zaufania. Wzrost liczby fałszywych profili i innych sztucznych treści online rodzi pytanie, w jakim stopniu ich obecność i nasza wiedza na ich temat mogą zmienić ten stan „domyślnej prawdy”, ostatecznie niszcząc zaufanie społeczne.

Zmiana naszych ustawień domyślnych

Przejście do świata, w którym to, co jest prawdziwe, jest nie do odróżnienia od tego, co nie, może również zmienić krajobraz kulturowy z bycia przede wszystkim prawdomównym na głównie sztuczny i zwodniczy.

Jeśli regularnie kwestionujemy prawdziwość tego, czego doświadczamy online, może to wymagać od nas ponownego skierowania naszego wysiłku umysłowego z przetwarzania samych wiadomości na przetwarzanie tożsamości posłańca. Innymi słowy, powszechne korzystanie z wysoce realistycznych, choć sztucznych treści internetowych może wymagać od nas innego myślenia – w sposób, którego się nie spodziewaliśmy.

W psychologii używamy terminu zwanego „monitorowaniem rzeczywistości”, w jaki sposób prawidłowo identyfikujemy, czy coś pochodzi ze świata zewnętrznego, czy z wnętrza naszych mózgów. Postęp technologii, które mogą tworzyć fałszywe, ale bardzo realistyczne twarze, obrazy i rozmowy wideo, oznacza, że monitorowanie rzeczywistości musi opierać się na informacjach innych niż nasze własne osądy. Wzywa również do szerszej dyskusji na temat tego, czy ludzkość wciąż może sobie pozwolić na zerwanie z prawdą.

Kluczowe jest, aby ludzie byli bardziej krytyczni podczas oceny cyfrowych twarzy. Może to obejmować odwrotne wyszukiwanie obrazów w celu sprawdzenia, czy zdjęcia są autentyczne, ostrożność w stosunku do profili w mediach społecznościowych z niewielką ilością danych osobowych lub dużą liczbą obserwujących oraz świadomość potencjalnego wykorzystania technologii deepfake do niecnych celów.

Kolejną granicą w tym obszarze powinny być ulepszone algorytmy wykrywania fałszywych cyfrowych twarzy. Można je następnie osadzić na platformach mediów społecznościowych, aby pomóc nam odróżnić prawdziwe od fałszywych, jeśli chodzi o twarze nowych połączeń.

O autorze

Manosa Tsakirisa, profesor psychologii, dyrektor Centrum Polityki Uczuć, Royal Holloway University of London

Artykuł został opublikowany ponownie Konwersacje na licencji Creative Commons. Przeczytać oryginalny artykuł.