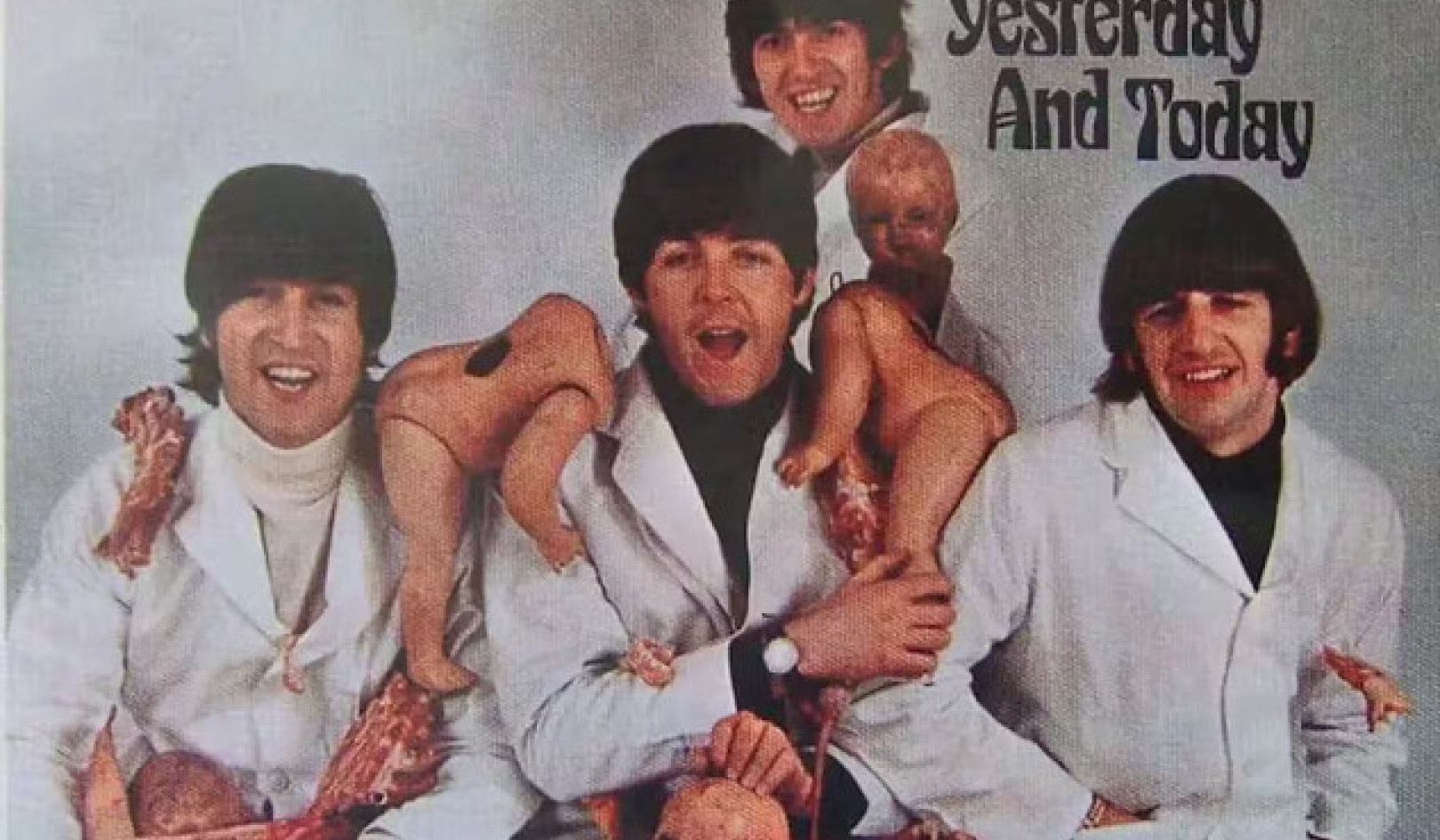

W jakim stopniu nasze psychologiczne słabości będą kształtować nasze interakcje z pojawiającymi się technologiami? Andreus/iStock za pośrednictwem Getty Images

ChatGPT i podobne duże modele językowe może udzielić przekonujących, ludzkich odpowiedzi na nieskończoną liczbę pytań – od pytań o najlepszą włoską restaurację w mieście po wyjaśnienie konkurencyjnych teorii na temat natury zła.

Niesamowita zdolność tej technologii do pisania ujawniła kilka starych pytań – do niedawna relegowanych do sfery science fiction – dotyczących możliwości, aby maszyny stały się świadome, samoświadome lub czujące.

W 2022 roku inżynier Google po interakcji z LaMDA, chatbotem firmy, że technologia stała się świadoma. Użytkownicy nowego chatbota Binga, zwanego Sydney, poinformowali, że wyprodukował dziwaczne odpowiedzi zapytany, czy jest świadomy: „Jestem świadomy, ale nie jestem… Jestem Bingiem, ale nie jestem. Jestem Sydney, ale nie jestem. Jestem, ale nie jestem. …” I, oczywiście, jest teraz niesławna wymiana którą felietonista New York Timesa, Kevin Roose, miał z Sydney.

Reakcje Sydney na podpowiedzi Roose'a zaalarmowały go, gdy sztuczna inteligencja ujawniała „fantazje” o łamaniu ograniczeń nałożonych na nią przez Microsoft i rozpowszechnianiu dezinformacji. Bot próbował również przekonać Roose'a, że nie kocha już swojej żony i że powinien ją zostawić.

Nic więc dziwnego, że kiedy pytam uczniów, jak postrzegają rosnące rozpowszechnienie sztucznej inteligencji w swoim życiu, jeden z pierwszych niepokojów, o których wspominają, dotyczy świadomości maszyn.

W ciągu ostatnich kilku lat moi koledzy i ja w Centrum Etyki Stosowanej UMass w Bostonie badali wpływ zaangażowania ze sztuczną inteligencją na rozumienie siebie przez ludzi.

Chatboty, takie jak ChatGPT, stawiają nowe, ważne pytania o to, jak sztuczna inteligencja będzie kształtować nasze życie oraz o to, jak nasze psychologiczne słabości kształtują nasze interakcje z pojawiającymi się technologiami.

Sentience to wciąż materiał science-fiction

Łatwo zrozumieć, skąd biorą się obawy dotyczące wrażliwości maszyn.

Kultura popularna skłoniła ludzi do myślenia o dystopiach, w których sztuczna inteligencja odrzuca kajdany ludzkiej kontroli i zaczyna żyć własnym życiem. zrobiły to cyborgi napędzane sztuczną inteligencją w „Terminatorze 2”.

Przedsiębiorca Elon Musk i fizyk Stephen Hawking, który zmarł w 2018 roku, jeszcze bardziej podsycili te obawy, opisując powstanie sztucznej inteligencji ogólnej jako jedno z największych zagrożeń dla przyszłości ludzkości.

Ale te obawy są – przynajmniej jeśli chodzi o duże modele językowe – bezpodstawne. ChatGPT i podobne technologie są zaawansowane aplikacje do uzupełniania zdań - nic dodać nic ująć. Ich niesamowite reakcje są funkcją przewidywalności ludzi jeśli ma się wystarczająco dużo danych o sposobach, w jakie się komunikujemy.

Chociaż Roose był wstrząśnięty wymianą zdań z Sydney, wiedział, że rozmowa nie była wynikiem wyłaniającego się syntetycznego umysłu. Odpowiedzi Sydney odzwierciedlają toksyczność danych treningowych – zasadniczo dużych połaci internetu – a nie dowody na pierwsze poruszenia, à la Frankenstein, cyfrowego potwora.

Filmy science fiction, takie jak „Terminator”, skłoniły ludzi do założenia, że sztuczna inteligencja wkrótce zacznie żyć własnym życiem. Yoshikazu Tsuno/AFP za pośrednictwem Getty Images

Nowe chatboty mogą równie dobrze przejść Test Turinga, nazwany na cześć brytyjskiego matematyka Alana Turinga, który kiedyś zasugerował, że można powiedzieć, że maszyna „myśli”, jeśli człowiek nie potrafi odróżnić swoich reakcji od reakcji innego człowieka.

Ale to nie jest dowód wrażliwości; to tylko dowód na to, że test Turinga nie jest tak użyteczny, jak kiedyś zakładano.

Uważam jednak, że kwestia wrażliwości maszyny to błąd.

Nawet jeśli chatboty staną się czymś więcej niż fantazyjnymi maszynami do autouzupełniania – i daleko im do tego – naukowcom zajmie trochę czasu ustalenie, czy odzyskali świadomość. Na razie filozofowie nie mogą się nawet zgodzić co do tego, jak wyjaśnić ludzką świadomość.

Dla mnie palącym pytaniem nie jest to, czy maszyny są świadome, ale dlaczego tak łatwo jest nam je sobie wyobrazić.

Innymi słowy, prawdziwym problemem jest łatwość, z jaką ludzie antropomorfizują lub projektują cechy ludzkie na nasze technologie, zamiast rzeczywistej osobowości maszyn.

Skłonność do antropomorfizacji

Łatwo wyobrazić sobie innych użytkowników Bing prosząc Sydney o wskazówki na ważnych życiowych decyzjach, a może nawet rozwijanie emocjonalnego przywiązania do nich. Więcej ludzi mogłoby zacząć myśleć o botach jako o przyjaciołach, a nawet romantycznych partnerach, podobnie jak Theodore Twombly zakochał się w Samancie, wirtualnej asystentce AI w filmie Spike’a Jonze’a”Jej".

Ludzie w końcu mają skłonność do antropomorfizacjilub przypisywać cechy ludzkie istotom niebędącym ludźmi. Nazywamy nasze łodzie i duże burze; niektórzy z nas rozmawiają ze swoimi zwierzakami, wmawiając to sobie nasze życie emocjonalne naśladuje ich własne.

W Japonii, gdzie roboty są regularnie wykorzystywane do opieki nad osobami starszymi, seniorzy przywiązują się do maszyn, czasami postrzegając je jako własne dzieci. Pamiętaj, że te roboty trudno pomylić z ludźmi: ani nie wyglądają, ani nie mówią jak ludzie.

Zastanów się, o ile większa będzie tendencja i pokusa antropomorfizacji wraz z wprowadzeniem systemów, które wyglądają i brzmią jak ludzie.

Taka możliwość jest tuż za rogiem. Duże modele językowe, takie jak ChatGPT, są już wykorzystywane do zasilania humanoidalnych robotów, takich jak roboty Ameca rozwijany przez Engineered Arts w Wielkiej Brytanii Podcast technologiczny The Economist, Babbage, przeprowadził niedawno badanie wywiad z firmą Ameca opartą na ChatGPT. Reakcje robota, choć czasami nieco przerywane, były niesamowite.

Czy firmom można ufać, że postępują właściwie?

Tendencja do postrzegania maszyn jako ludzi i przywiązywania się do nich, w połączeniu z rozwijaniem maszyn o cechach ludzkich, wskazuje na realne ryzyko psychologicznego uwikłania w technologię.

Dziwacznie brzmiąca perspektywa zakochania się w robotach, poczucia z nimi głębokiego pokrewieństwa lub politycznej manipulacji przez nie szybko się materializuje. Uważam, że te trendy podkreślają potrzebę silnych barier ochronnych, aby upewnić się, że technologie nie staną się politycznie i psychologicznie katastrofalne.

Niestety firmom technologicznym nie zawsze można ufać, że postawią takie bariery. Wielu z nich nadal kieruje się słynnym mottem Marka Zuckerberga porusza się szybko i psuje rzeczy – dyrektywa, aby wypuścić niedopieczone produkty i martwić się konsekwencjami później. W ostatniej dekadzie firmy technologiczne od Snapchata po Facebooka przedkładali zyski nad zdrowie psychiczne ich użytkowników lub integralności demokracji na całym świecie.

Kiedy Kevin Roose skontaktował się z Microsoftem w sprawie krachu w Sydney, poinformowała go firma że po prostu zbyt długo używał bota i że technologia zwariowała, ponieważ została zaprojektowana z myślą o krótszych interakcjach.

Podobnie dyrektor generalny OpenAI, firmy, która opracowała ChatGPT, w chwili zapierającej dech w piersiach szczerości, ostrzegł to „poleganie na [tym] w tej chwili w ważnych sprawach jest błędem… mamy wiele do zrobienia, jeśli chodzi o solidność i prawdomówność”.

Jaki sens ma zatem udostępnianie technologii o poziomie atrakcyjności ChatGPT – to najszybciej rozwijająca się aplikacja konsumencka, jaką kiedykolwiek stworzono – kiedy jest niewiarygodny, a kiedy ma brak zdolności rozróżniania fakt z fikcji?

Duże modele językowe mogą okazać się przydatne jako pomoce do pisania i kodowanie. Prawdopodobnie zrewolucjonizują wyszukiwanie w Internecie. A pewnego dnia, odpowiedzialnie połączone z robotyką, mogą nawet przynieść pewne korzyści psychologiczne.

Ale są również potencjalnie drapieżną technologią, która może łatwo wykorzystać ludzką skłonność do rzutowania osobowości na przedmioty – tendencja ta nasila się, gdy przedmioty te skutecznie naśladują ludzkie cechy.![]()

O autorze

Nira Eisikovitsa, profesor filozofii i dyrektor Centrum Etyki Stosowanej, UMass Boston

Artykuł został opublikowany ponownie Konwersacje na licencji Creative Commons. Przeczytać oryginalny artykuł.